Instal Hadoop Multinode Cluster Menggunakan CDH4 di Rhel/Centos 6.5

- 2705

- 765

- Dwayne Hackett

Hadoop adalah kerangka kerja pemrograman sumber terbuka yang dikembangkan oleh Apache untuk memproses data besar. Itu menggunakan HDFS (Sistem file terdistribusi Hadoop) untuk menyimpan data di semua datasodes di cluster secara distributif dan model MapReduce untuk memproses data.

Instal Hadoop Multinode Cluster

Instal Hadoop Multinode Cluster Namenode (Nn) adalah master daemon yang mengontrol HDFS Dan JobTracker (JT) adalah master daemon untuk mesin mapreduce.

Persyaratan

Dalam tutorial ini saya menggunakan dua Centos 6.3 VMS 'menguasai' Dan 'node'yaitu. (Master dan Node adalah nama host saya). IP 'master' adalah 172.21.17.175 dan simpul IP '172.21.17.188'. Instruksi berikut juga berfungsi RHEL/Centos 6.X versi.

Pada master

[[email dilindungi] ~]# hostname menguasai

[[email dilindungi] ~]# ifconfig | grep 'inet addr' | head -1 inet addr:172.21.17.175 Bcast: 172.21.19.255 topeng: 255.255.252.0

Di node

[[email dilindungi] ~]# hostname node

[[email dilindungi] ~]# ifconfig | grep 'inet addr' | head -1 inet addr:172.21.17.188 Bcast: 172.21.19.255 topeng: 255.255.252.0

Pertama pastikan bahwa semua host cluster ada '/etc/host'File (di setiap node), jika Anda tidak memiliki DNS yang diatur.

Pada master

[[Email Dilindungi] ~]# Cat /etc /Hosts 172.21.17.175 Master 172.21.17.188 Node

Di node

[[Email Dilindungi] ~]# Cat /etc /Hosts 172.21.17.197 Qabox 172.21.17.176 Tanah Ansible

Menginstal Hadoop Multinode Cluster di Centos

Kami menggunakan resmi CDH Repositori untuk diinstal CDH4 pada semua host (master dan node) di sebuah cluster.

Langkah 1: Unduh Instal Repositori CDH

Pergi ke halaman unduhan CDH resmi dan ambil CDH4 (i.e. 4.6) versi atau Anda dapat menggunakan berikut wget Perintah untuk mengunduh repositori dan menginstalnya.

Di rhel/centos 32-bit

# wget http: // arsip.Cloudera.com/cdh4/one-click-install/redhat/6/i386/cloudera-cdh-4-0.I386.rpm # yum ---nogpgcheck localinstall cloudera-cdh-4-0.I386.RPM

Di rhel/centos 64-bit

# wget http: // arsip.Cloudera.com/cdh4/one-click-install/redhat/6/x86_64/cloudera-cdh-4-0.x86_64.rpm # yum ---nogpgcheck localinstall cloudera-cdh-4-0.x86_64.RPM

Sebelum menginstal Hadoop Multinode Cluster, tambahkan kunci GPG publik cloudera ke repositori Anda dengan menjalankan salah satu perintah berikut sesuai dengan arsitektur sistem Anda.

## pada sistem 32-bit ## # rpm -Import http: // arsip.Cloudera.com/cdh4/redhat/6/i386/cdh/rpm-gpg-key-cloudera

## pada sistem 64-bit ## # rpm -Import http: // arsip.Cloudera.com/cdh4/redhat/6/x86_64/cdh/rpm-gpg-ke-cloudera

Langkah 2: Setup JobTracker & Namenode

Selanjutnya, jalankan perintah berikut untuk menginstal dan mengatur JobTracker dan Namenode di Master Server.

[[email dilindungi] ~]# yum bersih semua [[email dilindungi] ~]# yum instal hadoop-0.20-Mapreduce-Jobtracker

[[email dilindungi] ~]# yum bersih semua [[email dilindungi] ~]# yum instal hadoop-hdfs-namenode

Langkah 3: Setup Node Nama Sekunder

Sekali lagi, jalankan perintah berikut di server master untuk mengatur node nama sekunder.

[[email dilindungi] ~]# yum bersih semua [[email dilindungi] ~]# yum instal hadoop-hdfs-secondarynam

Langkah 4: Setup TaskTracker & Datanode

Selanjutnya, setup TaskTracker & DataNode pada semua host cluster (node) kecuali jobtracker, namenode, dan host namenode sekunder (atau siaga) (pada node dalam kasus ini).

[[email dilindungi] ~]# yum bersih semua [[email dilindungi] ~]# yum instal hadoop-0.20-Mapreduce-Tasktracker Hadoop-HDFS-Datanode

Langkah 5: Klien Pengaturan Hadoop

Anda dapat menginstal Hadoop Client pada mesin terpisah (dalam hal ini saya telah menginstalnya di DataNode Anda dapat menginstalnya di mesin apa pun).

[[email dilindungi] ~]# yum install hadoop-client

Langkah 6: Menyebarkan HDF pada node

Sekarang jika kita selesai dengan langkah -langkah di atas, mari bergerak maju untuk menggunakan HDFS (harus dilakukan pada semua node).

Salin konfigurasi default ke /etc/hadoop Direktori (pada setiap node dalam cluster).

[[email dilindungi] ~]# cp -r/etc/hadoop/conf.dist/etc/hadoop/conf.my_cluster

[[email dilindungi] ~]# cp -r/etc/hadoop/conf.dist/etc/hadoop/conf.my_cluster

Menggunakan alternatif Perintah untuk mengatur direktori khusus Anda, sebagai berikut (pada setiap node dalam cluster).

[[email dilindungi] ~]# alternatif --verbose --install/etc/hadoop/conf hadir-conf/etc/hadoop/conf.my_cluster 50 bacaan/var/lib/alternatif/hadoop-conf [[email dilindungi] ~]# alternatif --set hadoop-conf/etc/hadoop/conf.my_cluster

[[email dilindungi] ~]# alternatif --verbose --install/etc/hadoop/conf hadir-conf/etc/hadoop/conf.my_cluster 50 bacaan/var/lib/alternatif/hadoop-conf [[email dilindungi] ~]# alternatif --set hadoop-conf/etc/hadoop/conf.my_cluster

Langkah 7: Menyesuaikan file konfigurasi

Sekarang buka 'situs inti.xml'File dan Perbarui "FS.defaultfs”Pada setiap node di cluster.

[[email dilindungi] conf]# cat/etc/hadoop/conf/core-site.xml

FS.defaultfs hdfs: // master/

[[email dilindungi] conf]# cat/etc/hadoop/conf/core-site.xml

FS.defaultfs hdfs: // master/

Pembaruan berikutnya “dfs.izin.SuperUserGroup" di dalam HDFS-SITE.xml di setiap node di cluster.

[[email dilindungi] conf]# cat/etc/hadoop/conf/hdfs-site.xml

dfs.nama.dir /var/lib/hadoop-hdfs/cache/hdfs/dfs/name dfs.izin.SuperUserGroup Hadoop

[[email dilindungi] conf]# cat/etc/hadoop/conf/hdfs-site.xml

dfs.nama.dir /var/lib/hadoop-hdfs/cache/hdfs/dfs/name dfs.izin.SuperUserGroup Hadoop

Catatan: Harap pastikan bahwa, konfigurasi di atas hadir di semua node (lakukan pada satu node dan jalankan scp untuk menyalin pada sisa node).

Langkah 8: Mengkonfigurasi Direktori Penyimpanan Lokal

Perbarui “DFS.nama.dir atau dfs.namenode.nama.dir ”di 'hdfs-site.xml 'pada namenode (pada master dan node). Harap ubah nilainya seperti yang disorot.

[[email dilindungi] conf]# cat/etc/hadoop/conf/hdfs-site.xml

dfs.namenode.nama.dir File: /// data/1/dfs/nn,/nfsmount/dfs/nn

[[email dilindungi] conf]# cat/etc/hadoop/conf/hdfs-site.xml

dfs.datanode.data.dir File: /// data/1/dfs/dn,/data/2/dfs/dn,/data/3/dfs/dn

Langkah 9: Buat direktori & kelola izin

Jalankan perintah di bawah ini untuk membuat Struktur Direktori & Kelola Izin Pengguna pada NAMENODE (MASTER) DAN MESIN DATANODE (NODE).

[[email dilindungi]]# mkdir -p/data/1/dfs/nn/nfsmount/dfs/nn [[email dilindungi]]# chmod 700/data/1/dfs/nn/nfsmount/dfs/nn

[[email dilindungi]]# mkdir -p/data/1/dfs/dn/data/2/dfs/dn/data/3/dfs/dn/data/4/dfs/dn [[email dilindungi]]# chown -R HDFS: HDFS/Data/1/DFS/NN/NFSMOUNT/DFS/NN/DATA/1/DFS/DN/DATA/2/DFS/DN/DATA/3/DFS/DN/DATA/4/DFS/ dn

Format namenode (pada master), dengan menerbitkan perintah berikut.

[[email dilindungi] conf]# sudo -u hdfs hdfs namenode -format

Langkah 10: Mengkonfigurasi Namenode Sekunder

Tambahkan properti berikut ke HDFS-SITE.xml file dan ganti nilai seperti yang ditunjukkan pada master.

dfs.namenode.HTTP-TEPAT 172.21.17.175: 50070 Alamat dan port tempat namenode UI akan mendengarkan.

Catatan: Dalam nilai kasus kami harus berupa alamat ip master vm.

Sekarang mari kita berikan mrv1 (peta-reduce versi 1). Membuka 'Situs Mapred.xml'File Nilai berikut seperti yang ditunjukkan.

[[email dilindungi] conf]# cp hdfs-site.xml situs mapred.xml [[email dilindungi] conf]# vi-situs mapred.xml [[email dilindungi] conf]# cat mapred-site.xml

Mapred.pekerjaan.Pelacak Master: 8021

Selanjutnya, salin 'Situs Mapred.xmlfile ke mesin simpul menggunakan perintah scp berikut.

[[email dilindungi] conf]# scp/etc/hadoop/conf/mapred-site.xml node:/etc/hadoop/conf/mapred-site.xml 100% 200 0.2kb/s 00:00

Sekarang Konfigurasikan Direktori Penyimpanan Lokal untuk Digunakan oleh MRV1 Daemons. Lagi buka 'Situs Mapred.xml'File dan buat perubahan seperti yang ditunjukkan di bawah ini untuk setiap taskTracker.

Mapred.lokal.dir Â/data/1/papred/lokal,/data/2/papred/lokal,/data/3/papred/lokal

Setelah menentukan direktori ini di 'Situs Mapred.xml'File, Anda harus membuat direktori dan menetapkan izin file yang benar kepada mereka di setiap node di cluster Anda.

mkdir -p/data/1/papred/lokal/data/2/papred/lokal/data/3/papred/lokal/data/4/papred/lokal chown -r mapred: hadoop/data/1/papred/lokal/lokal/ Data/2/Mapred/Lokal/Data/3/Mapred/Lokal/Data/4/Mapred/Lokal

Langkah 10: Mulai HDFS

Sekarang jalankan perintah berikut untuk memulai HDF di setiap node di cluster.

[[email dilindungi] conf]# for x in 'cd /etc /init.D ; LS Hadoop-hdfs-*'; melakukan layanan sudo $ x mulai; Selesai

[[email dilindungi] conf]# for x in 'cd /etc /init.D ; LS Hadoop-hdfs-*'; melakukan layanan sudo $ x mulai; Selesai

Langkah 11: Buat direktori HDFS /TMP dan MapReduce /VAR

Itu diperlukan untuk membuat /tmp dengan izin yang tepat seperti yang disebutkan di bawah ini.

[[email dilindungi] conf]# sudo -u hdfs hadoop fs -mkdir /tmp [[email dilindungi] conf]# sudo -u hdfs hadoop fs -chmod -r 1777 /tmp

[[email dilindungi] conf]# sudo -u hdfs hadoop fs -mkdir -p/var/lib/hadoop -hdfs/cache/papred/mapred/pementasan [[email dilindungi] conf]# sudo -u hdfs hadoop fs -chmod 1777/var/lib/hadoop -hdfs/cache/papred/papred/pementasan [[email dilindungi] conf]# sudo -u hdfs hadoop fs -chown -r mapred/var/lib/hadoop -hdfs/cache/mapred

Sekarang verifikasi struktur file HDFS.

[[Email Dilindungi] ode conf]# sudo -u hdfs hadoop fs -ls -r / drwxrwxrwt-hdfs hadoop 0 2014-05-29 09:58 / TMP DRWXR-XR-X-HDFS HADOOP 0 2014-05-29 09 : 59 /var drwxr-xr-x-hdfs hadoop 0 2014-05-29 09:59 /var /lib drwxr-xr-x-hdfs hadoop 0 2014-05-29 09:59 /var /lib /hadoop-hdfs DRWXR-XR-X-HDFS HADOOP 0 2014-05-29 09:59/var/lib/hadoop-hdfs/cache drwxr-xr-x-Mapred Hadoop 0 2014-05-29 09:59/var/lib/hadoop -hdfs/cache/mapred drwxr-xr-x-papred hadoop 0 2014-05-29 09:59/var/lib/hadoop-hdfs/cache/mapred/mapred drwxrwxrwt-mapred hadoop 0 2014-05-29 09:59 /var/lib/hadoop-hdfs/cache/papred/mapred/pementasan

Setelah Anda memulai HDF dan membuat '/tmp', tetapi sebelum Anda memulai JobTracker, silakan buat direktori HDFS yang ditentukan oleh' Mapred.sistem.parameter dir (secara default $ hadoop.TMP.dir/mapred/system dan ubah pemilik menjadi mapred.

[[email dilindungi] conf]# sudo -u hdfs hadoop fs -mkdir/tmp/mapred/system [[email dilindungi] conf]# sudo -u hdfs hadoop fs -chown mapred: hadoop/tmp/mapred/sistem

Langkah 12: Mulai MapReduce

Untuk memulai MapReduce: Harap mulai layanan TT dan JT.

Di setiap sistem tasktracker

[[email dilindungi] conf]# service hadoop-0.20-Mapreduce-TaskTracker Mulai Mulai TaskTracker: [OK] Memulai TaskTracker, Logging to/Var/Log/Hadoop-0.20-Mapreduce/Hadoop-Hadoop-Tasktracker-Node.keluar

Di sistem jobtracker

[[email dilindungi] conf]# service hadoop-0.20-Mapreduce-Jobtracker Mulai Mulai JobTracker: [OK] Memulai JobTracker, Logging to/Var/Log/Hadoop-0.20-Mapreduce/Hadoop-Hadoop-Jobtracker-Master.keluar

Selanjutnya, buat direktori home untuk setiap pengguna hadoop. Disarankan agar Anda melakukan ini di namenode; Misalnya.

[[email dilindungi] conf]# sudo -u hdfs hadoop fs -mkdirâ /user /[[email dilindungi] conf]# sudo -u hdfs hadoop fs -chown /pengguna /

Catatan: Di mana adalah nama pengguna Linux dari setiap pengguna.

Atau, Anda dapat membuat direktori home sebagai berikut.

[[email dilindungi] conf]# sudo -u hdfs hadoop fs -mkdir /user /$ user [[email dilindungi] conf]# sudo -u hdfs hadoop fs -chown $ user /user /user /$ user

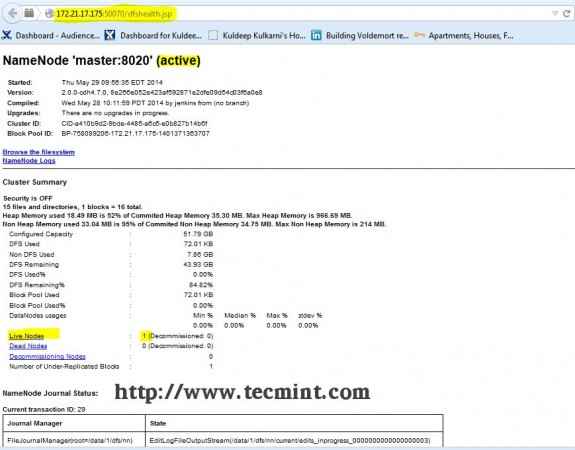

Langkah 13: Buka JT, NN UI dari Browser

Buka browser Anda dan ketik URL sebagai http: // ip_address_of_namenode: 50070 untuk mengakses namenode.

Antarmuka Hadoop Namenode

Antarmuka Hadoop Namenode Buka tab lain di browser Anda dan ketik URL sebagai http: // ip_address_of_jobtracker: 50030 untuk mengakses JobTracker.

Hadoop peta/mengurangi administrasi

Hadoop peta/mengurangi administrasi Prosedur ini telah berhasil diuji Rhel/Centos 5.X/6.X. Harap komentar di bawah jika Anda menghadapi masalah apa pun dengan instalasi, saya akan membantu Anda dengan solusi.

- « Buat situs web berbagi video Anda sendiri menggunakan 'Cumulusclips Script' di Linux

- Membuat host virtual, menghasilkan sertifikat & kunci SSL dan mengaktifkan CGI Gateway di Gentoo Linux »