Cara menginstal hadoop di ubuntu 18.04 Bionic Beaver Linux

- 1931

- 583

- Hector Kuhic

Apache Hadoop adalah kerangka kerja open source yang digunakan untuk penyimpanan terdistribusi serta pemrosesan data besar terdistribusi pada kelompok komputer yang berjalan pada perangkat keras komoditas. Hadoop menyimpan data dalam Sistem File Terdistribusi Hadoop (HDFS) dan pemrosesan data ini dilakukan dengan menggunakan MapReduce. Benang menyediakan API untuk meminta dan mengalokasikan sumber daya di Hadoop Cluster.

Kerangka kerja Apache Hadoop terdiri dari modul -modul berikut:

- Hadoop Common

- Sistem File Terdistribusi Hadoop (HDFS)

- BENANG

- Mapreduce

Artikel ini menjelaskan cara menginstal Hadoop Version 2 di Ubuntu 18.04. Kami akan menginstal HDFS (namenode dan datasode), benang, mapreduce pada cluster simpul tunggal dalam mode terdistribusi semu yang didistribusikan simulasi pada satu mesin. Setiap daemon hadoop seperti HDF, benang, mapreduce dll. akan berjalan sebagai proses java terpisah/individu.

Dalam tutorial ini Anda akan belajar:

- Cara Menambahkan Pengguna untuk Lingkungan Hadoop

- Cara Menginstal dan Mengkonfigurasi Oracle JDK

- Cara mengkonfigurasi ssh tanpa kata sandi

- Cara menginstal hadoop dan mengkonfigurasi file xml terkait yang diperlukan

- Cara Memulai Cluster Hadoop

- Cara Mengakses Namenode dan Web UI Web ResourceManager

Antarmuka pengguna web namenode.

Antarmuka pengguna web namenode. Persyaratan dan konvensi perangkat lunak yang digunakan

| Kategori | Persyaratan, konvensi atau versi perangkat lunak yang digunakan |

|---|---|

| Sistem | Ubuntu 18.04 |

| Perangkat lunak | Hadoop 2.8.5, Oracle JDK 1.8 |

| Lainnya | Akses istimewa ke sistem Linux Anda sebagai root atau melalui sudo memerintah. |

| Konvensi | # - mensyaratkan perintah linux yang diberikan untuk dieksekusi dengan hak istimewa root baik secara langsung sebagai pengguna root atau dengan menggunakan sudo memerintah$ - mensyaratkan perintah Linux yang diberikan untuk dieksekusi sebagai pengguna biasa |

Versi lain dari tutorial ini

Ubuntu 20.04 (fossa fokus)

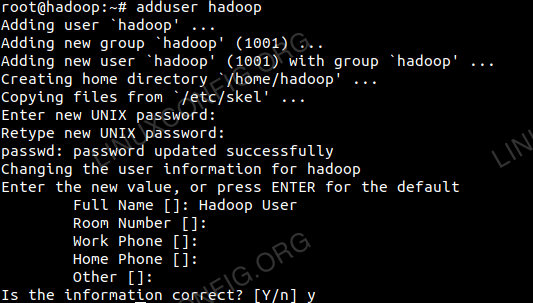

Tambahkan pengguna untuk lingkungan Hadoop

Buat pengguna dan grup baru menggunakan perintah:

# Tambahkan pengguna

Tambahkan pengguna baru untuk Hadoop.

Tambahkan pengguna baru untuk Hadoop.

Instal dan konfigurasikan oracle JDK

Unduh dan ekstrak arsip Java di bawah /memilih direktori.

# CD /OPT # TAR -XZVF JDK-8U192-LINUX-X64.ter.GZ

atau

$ tar -xzvf jdk-8u192-linux-x64.ter.GZ -C /Opt

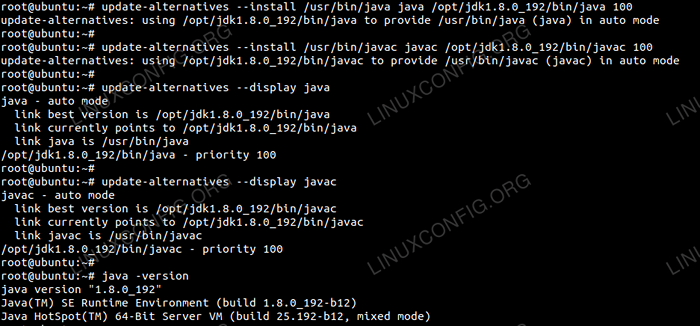

Untuk mengatur JDK 1.8 UPDATE 192 Sebagai JVM default kami akan menggunakan perintah berikut:

# UPDATE-ALTERNATIF--install/usr/bin/java java/opt/jdk1.8.0_192/bin/java 100 # pembaruan-alternatif --install/usr/bin/javac javac/opt/jdk1.8.0_192/bin/javac 100

Setelah instalasi untuk memverifikasi Java telah berhasil dikonfigurasi, jalankan perintah berikut:

# UPDATE-ALTERNATIF--Display Java # UPDATE-ALTERNATIF-DISPLAY JAVAC

Instalasi & Konfigurasi OracleJDK.

Instalasi & Konfigurasi OracleJDK. Konfigurasikan SSH tanpa kata sandi

Instal Open SSH Server dan Open SSH Client dengan perintah:

# sudo apt-get install openssh-server openssh-client

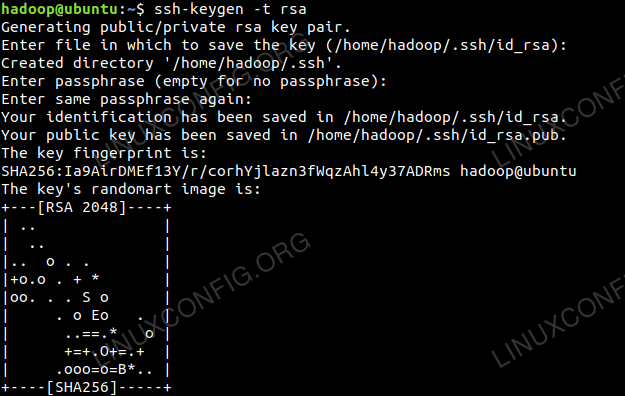

Menghasilkan pasangan kunci publik dan pribadi dengan perintah berikut. Terminal akan meminta untuk memasukkan nama file. Tekan MEMASUKI dan lanjutkan. Setelah itu salin formulir kunci publik id_rsa.pub ke otorisasi_keys.

$ ssh -keygen -t rsa $ cat ~/.ssh/id_rsa.pub >> ~//.ssh/otorisasi_keys

Konfigurasi SSH tanpa kata sandi.

Konfigurasi SSH tanpa kata sandi.

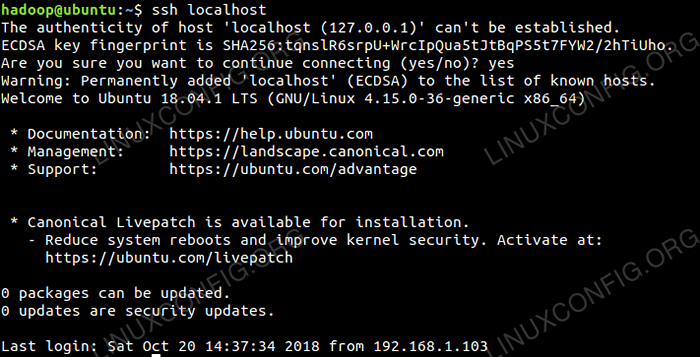

Verifikasi konfigurasi SSH tanpa kata sandi dengan perintah:

$ SSH Localhost

Pemeriksaan SSH tanpa kata sandi.

Pemeriksaan SSH tanpa kata sandi.

Instal Hadoop dan konfigurasikan file XML terkait

Unduh dan Ekstrak Hadoop 2.8.5 dari situs resmi Apache.

# tar -xzvf hadoop -2.8.5.ter.GZ

Menyiapkan Variabel Lingkungan

Edit Bashrc Untuk pengguna Hadoop melalui pengaturan variabel lingkungan Hadoop berikut:

Ekspor Hadoop_home =/home/hadoop/hadoop-2.8.5 export HADOOP_INSTALL=$HADOOP_HOME export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOME export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin Ekspor Hadoop_opts = "-Djava.perpustakaan.path = $ hadoop_home/lib/asli " Sumber .Bashrc di sesi login saat ini.

$ sumber ~/.Bashrc

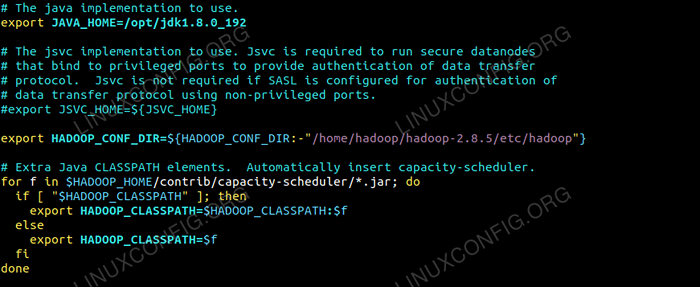

Edit Hadoop-env.SH file yang ada /etc/hadoop Di dalam direktori instalasi Hadoop dan membuat perubahan berikut dan periksa apakah Anda ingin mengubah konfigurasi lainnya.

Ekspor java_home =/opt/jdk1.8.0_192 Ekspor HADOOP_CONF_DIR = $ HADOOP_CONF_DIR:-"/HOME/HADOOP/HADOOP-2.8.5/etc/hadoop "  Perubahan Hadoop-Env.file sh.

Perubahan Hadoop-Env.file sh. Perubahan konfigurasi di situs inti.file xml

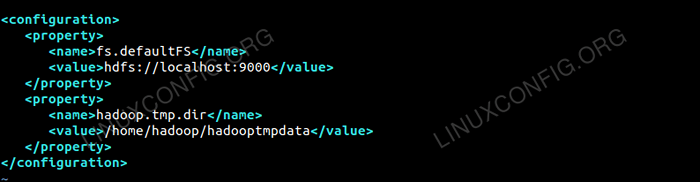

Edit situs inti.xml dengan vim atau Anda dapat menggunakan salah satu editor. File di bawah /etc/hadoop di dalam Hadoop direktori home dan tambahkan entri berikut.

FS.defaultfs hdfs: // localhost: 9000 Hadoop.TMP.dir /home/hadoop/hadooptmpdata Selain itu, buat direktori di bawah Hadoop folder rumah.

$ mkdir hadooptmpdata

Konfigurasi untuk situs inti.file xml.

Konfigurasi untuk situs inti.file xml. Perubahan Konfigurasi di HDFS-Site.file xml

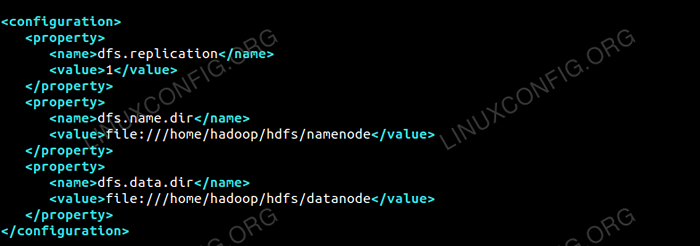

Edit HDFS-SITE.xml yang ada di bawah lokasi yang sama i.e /etc/hadoop di dalam Hadoop direktori instalasi dan buat Namenode/datasode direktori di bawah Hadoop Direktori Rumah Pengguna.

$ mkdir -p hdfs/namenode $ mkdir -p hdfs/datasode

dfs.replikasi 1 dfs.nama.dir File: /// home/hadoop/hdfs/namenode dfs.data.dir File: /// home/hadoop/hdfs/datasode  Konfigurasi untuk HDFS-Site.file xml.

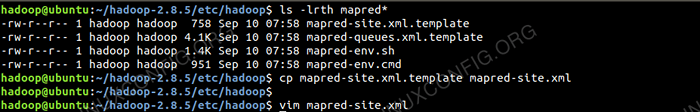

Konfigurasi untuk HDFS-Site.file xml. Perubahan konfigurasi di situs mapred.file xml

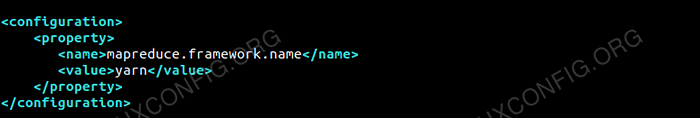

Salin Situs Mapred.xml dari Situs Mapred.xml.templat menggunakan cp perintah dan kemudian edit Situs Mapred.xml ditempatkan /etc/hadoop di bawah Hadoop direktori instilasi dengan perubahan berikut.

$ cp-site mapred.xml.Template situs mapred.xml

Membuat situs mapred baru.file xml.

Membuat situs mapred baru.file xml. Mapreduce.kerangka.nama benang  Konfigurasi untuk situs mapred.file xml.

Konfigurasi untuk situs mapred.file xml. Perubahan konfigurasi di situs benang.file xml

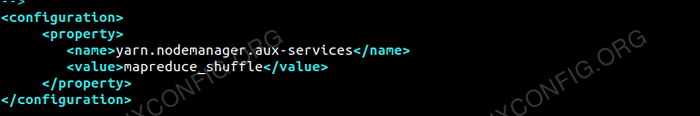

Edit situs benang.xml dengan entri berikut.

Mapreduceyarn.NodeManager.layanan aux MapReduce_shuffle  Konfigurasi untuk situs benang.file xml.

Konfigurasi untuk situs benang.file xml. Memulai klaster Hadoop

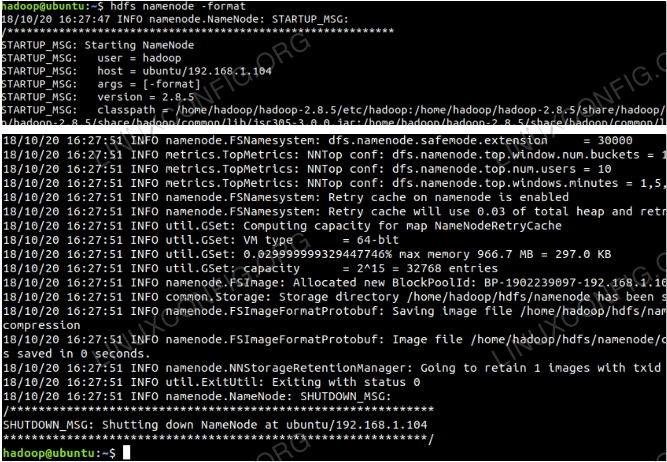

Format namenode sebelum menggunakannya untuk pertama kalinya. Saat pengguna HDFS menjalankan perintah di bawah ini untuk memformat namenode.

$ hdfs namenode -format

Format namenode.

Format namenode.

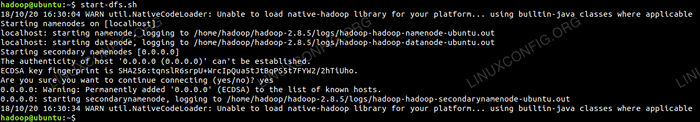

Setelah namenode diformat kemudian mulai HDF menggunakan start-dfs.SH naskah.

Memulai skrip startup DFS untuk memulai HDFS.

Memulai skrip startup DFS untuk memulai HDFS.

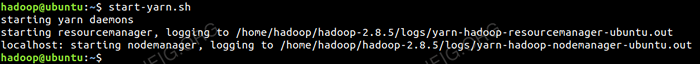

Untuk memulai layanan benang, Anda perlu menjalankan skrip mulai benang i.e. Mulai-Bukur.SH

Memulai skrip startup benang untuk memulai benang.

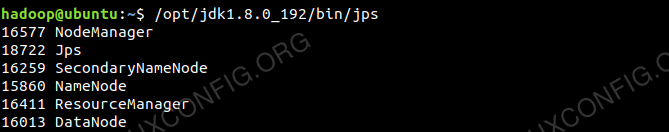

Memulai skrip startup benang untuk memulai benang. Untuk memverifikasi semua layanan/daemon Hadoop dimulai dengan sukses, Anda dapat menggunakan JPS memerintah.

/opt/jdk1.8.0_192/bin/JPS 20035 SecondaryNamenode 19782 DataDe 21671 JPS 20343 NODemanager 19625 Namenode 20187 Resourcemanagerer  Output Hadoop Daemons dari perintah JPS.

Output Hadoop Daemons dari perintah JPS.

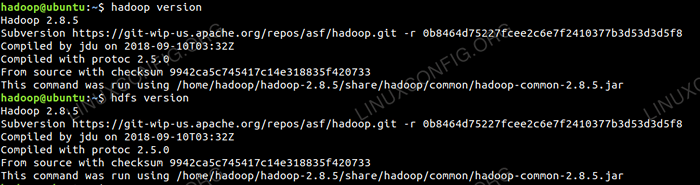

Sekarang kita dapat memeriksa versi Hadoop saat ini yang dapat Anda gunakan di bawah perintah:

$ Hadoop Versi

atau

Versi $ HDFS

Periksa versi Hadoop.

Periksa versi Hadoop.

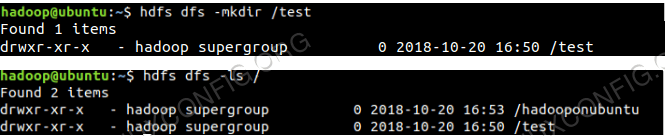

Antarmuka baris perintah HDFS

Untuk mengakses HDFS dan membuat beberapa direktori di atas DFS Anda dapat menggunakan HDFS CLI.

$ HDFS DFS -MKDIR /TEST $ HDFS DFS -MKDIR /HADOOPONUBUNTU $ HDFS DFS -LS /

Pembuatan Direktori HDFS Menggunakan HDFS CLI.

Pembuatan Direktori HDFS Menggunakan HDFS CLI.

Akses namenode dan benang dari browser

Anda dapat mengakses Web UI untuk Namenode dan Yarn Resource Manager melalui salah satu browser seperti Google Chrome/Mozilla Firefox.

Namenode Web UI - http: //: 50070

Antarmuka pengguna web namenode.

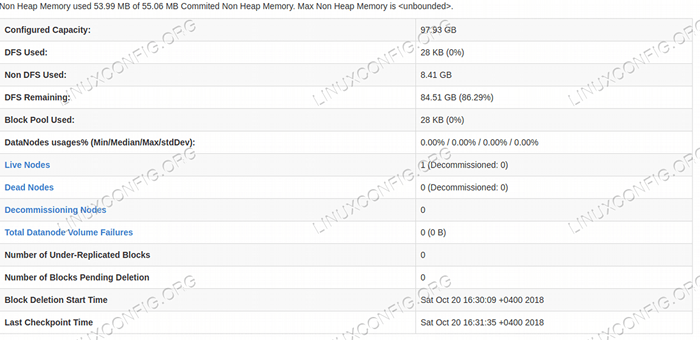

Antarmuka pengguna web namenode.  Detail HDFS dari antarmuka pengguna web namenode.

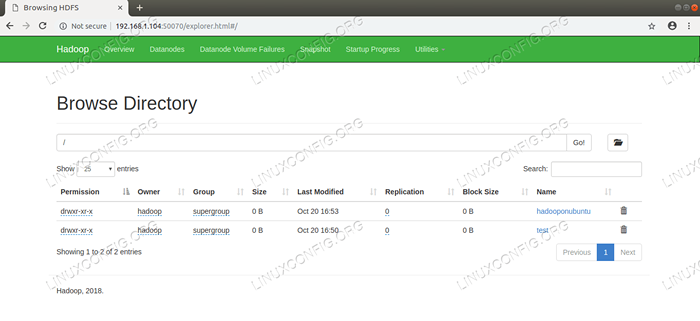

Detail HDFS dari antarmuka pengguna web namenode.  Penelusuran Direktori HDFS Melalui Antarmuka Pengguna Web Namenode.

Penelusuran Direktori HDFS Melalui Antarmuka Pengguna Web Namenode. Antarmuka web Yarn Resource Manager (RM) akan menampilkan semua pekerjaan yang berjalan di cluster Hadoop saat ini.

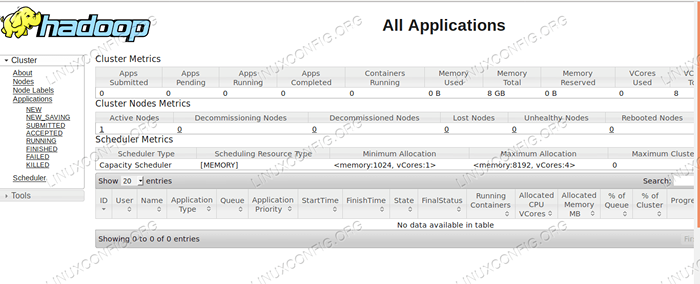

Web UI Manajer Sumber Daya - http: //: 8088

Antarmuka Pengguna Web Manajer Sumber Daya.

Antarmuka Pengguna Web Manajer Sumber Daya. Kesimpulan

Dunia mengubah cara beroperasi saat ini dan data besar memainkan peran utama dalam fase ini. Hadoop adalah kerangka kerja yang membuat hidup kita mudah saat mengerjakan set data besar. Ada perbaikan di semua lini. Masa Depan Menyenangkan.

Tutorial Linux Terkait:

- Ubuntu 20.04 Hadoop

- Hal -hal yang harus diinstal pada ubuntu 20.04

- Cara membuat cluster kubernetes

- Cara menginstal kubernet di ubuntu 20.04 FOSSA FOSSA Linux

- Hal -hal yang harus dilakukan setelah menginstal ubuntu 20.04 FOSSA FOSSA Linux

- Cara menginstal kubernet di ubuntu 22.04 Jammy Jellyfish…

- Hal -hal yang harus diinstal pada Ubuntu 22.04

- Bagaimana bekerja dengan WooCommerce Rest API dengan Python

- Cara mengelola cluster Kubernetes dengan Kubectl

- Pengantar Otomatisasi Linux, Alat dan Teknik

- « Cara Menginstal Android Studio di Manjaro 18 Linux

- Cara Menginstal Google Chrome di Manjaro 18 Linux »