Cara Menginstal Apache Kafka di Ubuntu 18.04

- 2875

- 723

- Ian Parker

Apache Kafka adalah platform streaming terdistribusi. Berguna untuk membangun jalur pipa data streaming real-time untuk mendapatkan data antara sistem atau aplikasi. Fitur lain yang berguna adalah aplikasi streaming waktu-nyata yang dapat mengubah aliran data atau bereaksi terhadap aliran data.

Tutorial ini akan membantu Anda menginstal Apache Kafka di Ubuntu 18.04, dan Ubuntu 16.04 Sistem Linux.

Langkah 1 - Instal Java

Apache kafka mengharuskan java untuk berlari. Anda harus menginstal Java di sistem Anda. Jalankan perintah di bawah ini untuk menginstal OpenJDK default pada sistem Anda dari PPA resmi. Anda juga dapat menginstal versi spesifik dari sini.

pembaruan apt sudosudo apt instal default-jdk

Langkah 2 - Unduh Apache Kafka

Unduh file biner Apache Kafka dari situs web unduhan resmi. Anda juga dapat memilih cermin terdekat untuk diunduh.

wget https: // dlcdn.Apache.org/kafka/3.2.0/kafka_2.13-3.2.0.tgz Kemudian ekstrak file arsip

TAR XZF KAFKA_2.13-3.2.0.tgzsudo mv kafka_2.13-3.2.0/usr/lokal/kafka

Langkah 3 - Mengatur file unit Systemd Kafka

Selanjutnya, buat file unit SystemD untuk layanan ZooKeeper dan Kafka. Ini akan membantu mengelola layanan kafka untuk memulai/berhenti menggunakan perintah Systemctl.

Pertama, buat file unit SystemD untuk ZooKeeper dengan perintah di bawah ini:

sudo vim/etc/systemd/system/zookeeperer.melayani Tambahkan konten di bawah ini:

[Unit] Deskripsi = Dokumentasi Server Apache ZooKeeper = http: // Zookeeperer.Apache.org membutuhkan = jaringan.Target Remote-FS.target setelah = jaringan.Target Remote-FS.Target [layanan] type = Simple execStart =/usr/local/kafka/bin/zooKeeper-server-start.sh/usr/local/kafka/config/zookeeperer.properti execstop =/usr/local/kafka/bin/zookeeper-server-stop.SH restart = on-abnormal [install] wantedby = multi-pengguna.target

Simpan file dan tutup.

Selanjutnya, untuk membuat file unit SystemD kafka menggunakan perintah berikut:

sudo vim/etc/systemd/system/kafka.melayani Tambahkan konten di bawah ini. Pastikan untuk mengatur yang benar Java_home jalur sesuai java yang diinstal pada sistem Anda.

[Unit] Deskripsi = Dokumentasi Server Apache Kafka = http: // kafka.Apache.org/dokumentasi.html membutuhkan = zooKeeper.Layanan [Layanan] Type = Simple Environment = "java_home =/usr/lib/jvm/java-1.11.0-OPENJDK-AMD64 "ExecStart =/usr/local/kafka/bin/kafka-server-start.sh/usr/local/kafka/config/server.properti execstop =/usr/local/kafka/bin/kafka-server-stop.sh [install] wantedby = multi-pengguna.target

Simpan file dan tutup.

Muat Ulang Daemon SystemD untuk menerapkan perubahan baru.

Systemctl Daemon-reload Langkah 4 - Mulai Kafka Server

Kafka membutuhkan zooKeeper jadi pertama -tama, mulailah server zookeeper di sistem Anda. Anda dapat menggunakan skrip yang tersedia dengan kafka untuk memulai instance zookeeper simpul tunggal.

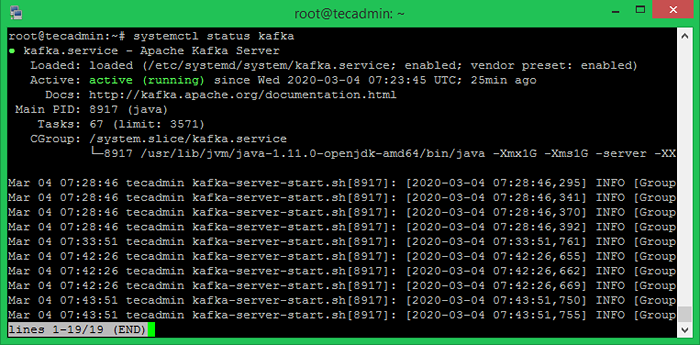

Sudo Systemctl Mulai Zookeeper Sekarang mulailah server kafka dan lihat status berjalan:

sudo systemctl mulai kafkaSudo Systemctl Status Kafka

Semua selesai. Instalasi Kafka telah berhasil diselesaikan. Bagian tutorial ini akan membantu Anda bekerja dengan server Kafka.

Langkah 5 - Buat topik di kafka

Kafka menyediakan beberapa skrip shell pra-dibangun untuk mengerjakannya. Pertama, buat topik bernama "Testtopic" dengan satu partisi dengan replika tunggal:

CD/USR/LOCAL/KAFKABIN/KAFKA-TOPICS.sh --create --bootstrap-server localhost: 9092--replikasi-faktor 1 --partisi 1-Testtopik TopikMembuat topik testtopic.

Faktor replikasi menjelaskan berapa banyak salinan data yang akan dibuat. Saat kami berjalan dengan satu contoh, pertahankan nilai ini 1.

Tetapkan opsi partisi sebagai jumlah broker yang Anda ingin data Anda terpecah antara. Saat kami berlari dengan satu broker, pertahankan nilai ini 1.

Anda dapat membuat beberapa topik dengan menjalankan perintah yang sama seperti di atas. Setelah itu, Anda dapat melihat topik yang dibuat di kafka dengan perintah yang berjalan di bawah ini:

BIN/KAFKA-TOPICS.SH - -list --zookeeper Localhost: 9092 testtopic tecadmintutorial1 tecadmintutorial2 Atau, alih-alih membuat topik secara manual, Anda juga dapat mengkonfigurasi broker Anda untuk membuat topik secara otomatis ketika topik yang tidak ada diterbitkan.

Langkah 6 - Kirim pesan ke kafka

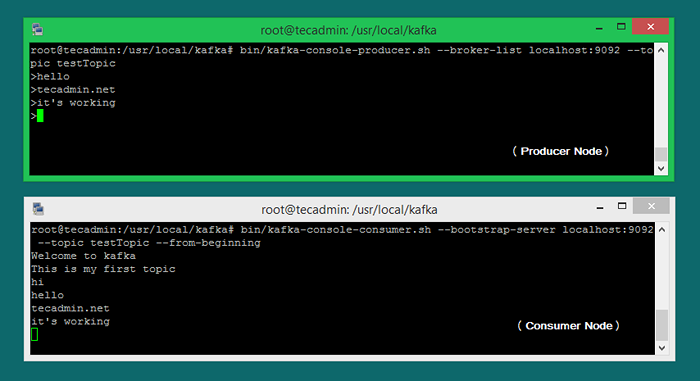

"Produser" adalah proses yang bertanggung jawab untuk memasukkan data ke dalam kafka kami. Kafka dilengkapi dengan klien baris perintah yang akan mengambil input dari file atau dari input standar dan mengirimkannya sebagai pesan ke kluster kafka. Kafka default mengirimkan setiap baris sebagai pesan terpisah.

Mari kita jalankan produser dan kemudian ketik beberapa pesan ke konsol untuk dikirim ke server.

Bin/Kafka-Console-Produser.SH --MBROKER-DISTHOST LOCAL: 9092-Testtopik Topik > Selamat Datang di Kafka> Ini adalah topik pertama saya> Anda dapat keluar dari perintah ini atau menjaga terminal ini tetap berjalan untuk pengujian lebih lanjut. Sekarang buka terminal baru untuk proses konsumen Kafka pada langkah berikutnya.

Langkah 7 - Menggunakan konsumen Kafka

Kafka juga memiliki konsumen baris perintah untuk membaca data dari kluster kafka dan menampilkan pesan ke output standar.

BIN/KAFKA-Console-Consumer.SH --Bootstrap-Server Localhost: 9092-Testtopic Testopik ---From-Beginning Selamat datang di kafka ini adalah topik pertama saya Sekarang, jika Anda masih menjalankan produser kafka (langkah #6) di terminal lain. Cukup ketik beberapa teks di terminal produser itu. itu akan segera terlihat di terminal konsumen. Lihat tangkapan layar di bawah ini dari produsen dan konsumen Kafka dalam bekerja:

Kesimpulan

Anda telah berhasil menginstal dan mengonfigurasi layanan kafka di mesin ubuntu linux Anda.

- « Cara menonaktifkan output dan email crontab di linux

- Cara menginstal S3CMD di Linux dan mengelola ember S3 »