Cara Menginstal dan Mengkonfigurasi Apache Hadoop di Centos & Fedora

- 4055

- 1248

- Miss Angelo Toy

Telah ada selama beberapa waktu sekarang, Hadoop telah menjadi salah satu solusi data besar open-source yang paling populer. Ini memproses data dalam batch dan terkenal dengan kemampuan komputasi yang dapat diskalakan, hemat biaya, dan terdistribusi. Ini adalah salah satu kerangka kerja open-source yang paling populer dalam analisis data dan ruang penyimpanan. Sebagai pengguna, Anda dapat menggunakannya untuk mengelola data Anda, menganalisis data itu, dan menyimpannya lagi - semuanya dengan cara otomatis. Dengan Hadoop diinstal pada sistem fedora Anda, Anda dapat mengakses layanan analitik yang penting dengan mudah.

Artikel ini mencakup cara menginstal Apache Hadoop di Centos dan Fedora Systems. Di artikel ini, kami akan menunjukkan cara menginstal Apache Hadoop di Fedora untuk penggunaan lokal serta server produksi.

1. Prerequsities

Java adalah persyaratan utama untuk menjalankan Hadoop pada sistem apa pun, jadi pastikan Anda telah menginstal Java pada sistem Anda menggunakan perintah berikut. Jika Anda tidak menginstal Java di sistem Anda, gunakan salah satu tautan berikut untuk menginstalnya terlebih dahulu.

- Cara menginstal java 8 di centos/rhel 7/6/5

2. Buat pengguna Hadoop

Kami merekomendasikan membuat akun normal (atau root) untuk Hadoop Working. Untuk membuat akun menggunakan perintah berikut.

Adduser Hadoop Passwd Hadoop

Setelah membuat akun, itu juga diperlukan untuk mengatur SSH berbasis kunci ke akunnya sendiri. Untuk melakukan ini gunakan, jalankan perintah berikut.

su -hadoop ssh -keygen -t rsa -p "-f ~/.SSH/ID_RSA Cat ~/.ssh/id_rsa.pub >> ~//.ssh/otorisasi_keys chmod 0600 ~/.ssh/otorisasi_keys

Mari kita verifikasi login berbasis kunci. Perintah di bawah ini tidak boleh meminta kata sandi tetapi pertama kali akan meminta untuk menambahkan RSA ke daftar host yang diketahui.

SSH Localhost Exit

3. Unduh Hadoop 3.1 arsip

Pada langkah ini, unduh Hadoop 3.1 file arsip sumber menggunakan perintah di bawah ini. Anda juga dapat memilih cermin unduhan alternatif untuk meningkatkan kecepatan unduhan.

CD ~ wget http: // www-eu.Apache.org/dist/hadoop/common/hadoop-3.1.0/Hadoop-3.1.0.ter.GZ TAR XZF HADOOP-3.1.0.ter.GZ MV Hadoop-3.1.0 Hadoop

4. Pengaturan mode terdistribusi semu Hadoop

4.1. Setup variabel lingkungan hadoop

Pertama, kita perlu mengatur penggunaan variabel lingkungan oleh Hadoop. Edit ~/.Bashrc file dan tambahkan nilai berikut di akhir file.

export HADOOP_HOME=/home/hadoop/hadoop export HADOOP_INSTALL=$HADOOP_HOME export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOME export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export PATH=$PATH:$ HADOOP_HOME/SBIN: $ HADOOP_HOME/BIN

Sekarang terapkan perubahan dalam lingkungan berjalan saat ini

Sumber ~/.Bashrc

Sekarang edit $ Hadoop_home/etc/hadoop/hadoop-env.SH file dan set Java_home Variabel Lingkungan. Ubah Java Path sesuai pemasangan di sistem Anda. Jalur ini dapat bervariasi sesuai dengan versi sistem operasi Anda dan sumber instalasi. Jadi pastikan Anda menggunakan jalur yang benar.

Ekspor java_home =/usr/lib/jvm/java-8-oracle

4.2. Mengatur file konfigurasi Hadoop

Hadoop memiliki banyak file konfigurasi, yang perlu dikonfigurasi sesuai persyaratan infrastruktur Hadoop Anda. Mari kita mulai dengan konfigurasi dengan pengaturan klaster node tunggal Hadoop dasar. Pertama, arahkan ke lokasi di bawah

cd $ hadoop_home/etc/hadoop

Edit situs inti.xml

FS.bawaan.Nama hdfs: // localhost: 9000

Edit HDFS-Site.xml

dfs.Replikasi 1 DFS.nama.File dir: /// home/hadoop/hadoopdata/hdfs/namenode dfs.data.File dir: /// home/hadoop/hadoopdata/hdfs/datanode

Edit-situs Mapred.xml

Mapreduce.kerangka.Nama benang

Edit situs benang.xml

benang.NodeManager.aux-services mapreduce_shuffle

4.3. Format namenode

Sekarang format namenode menggunakan perintah berikut, pastikan direktori penyimpanan itu

HDFS Namenode -Format

Output sampel:

PERINGATAN:/home/hadoop/hadoop/log tidak ada. Menciptakan. 2018-05-02 17: 52: 09.678 Info Namenode.Namenode: startup_msg: /********************************************* *************** startup_msg: Memulai namenode startup_msg: host = tecadmin/127.0.1.1 startup_msg: args = [-format] startup_msg: versi = 3.1.0… 2018-05-02 17: 52: 13.717 Info Umum.Penyimpanan: Direktori Penyimpanan/Rumah/Hadoop/HadoopData/HDFS/Namenode telah berhasil diformat. 2018-05-02 17: 52: 13.806 info namenode.FSIMAGEFORMATPROTOBUF: Menyimpan File Gambar/Rumah/Hadoop/HadoopData/HDFS/Namenode/Saat Ini/FSIMAGE.CKPT_0000000000000000000 Menggunakan No Compression 2018-05-02 17: 52: 14.161 Info Namenode.FSIMAGEFORMATPROTOBUF: File Gambar/Rumah/Hadoop/HadoopData/HDFS/Namenode/Saat Ini/FSIMAGE.CKPT_0000000000000000000 Ukuran 391 byte disimpan dalam 0 detik . 2018-05-02 17: 52: 14.224 info namenode.NnstorageretentionManager: akan mempertahankan 1 gambar dengan txid> = 0 2018-05-02 17: 52: 14.282 info namenode.Namenode: shutdown_msg: /********************************************* *******************_Msg: Mematikan namenode di Tecadmin/127.0.1.1 *********************************************** ***********/

5. Mulai Hadoop Cluster

Mari kita mulai kluster hadoop Anda menggunakan skrip yang disediakan oleh Hadoop. Navigasi saja ke direktori $ hadoop_home/sbin Anda dan jalankan skrip satu per satu.

CD $ HADOOP_HOME/SBIN/

Sekarang jalankan start-dfs.SH naskah.

./start-dfs.SH

Output sampel:

Memulai namenodes pada [localhost] start datasodes memulai namenodes sekunder [tecadmin] 2018-05-02 18: 00: 32.565 peringatan util.NativeCodeloader: Tidak dapat memuat perpustakaan Native-Hadoop untuk platform Anda ... Menggunakan kelas builtin-java yang berlaku

Sekarang jalankan Mulai-Bukur.SH naskah.

./mulai-yarn.SH

Output sampel:

Mulai ResourceManager Memulai Nodemanagers

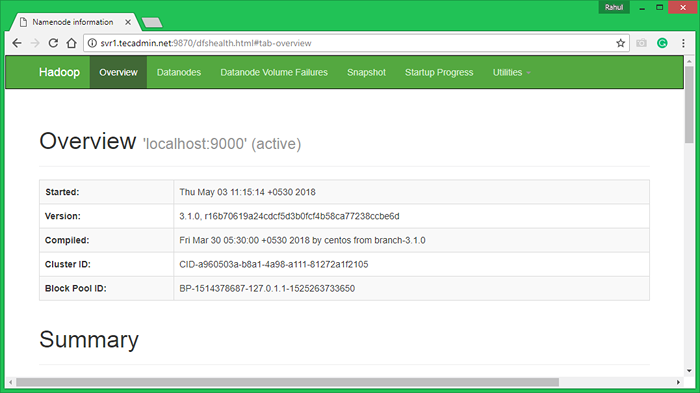

6. Akses Layanan Hadoop di Browser

Hadoop Namenode dimulai pada port 9870 default. Akses server Anda di port 9870 di browser web favorit Anda.

http: // svr1.tecadmin.net: 9870/

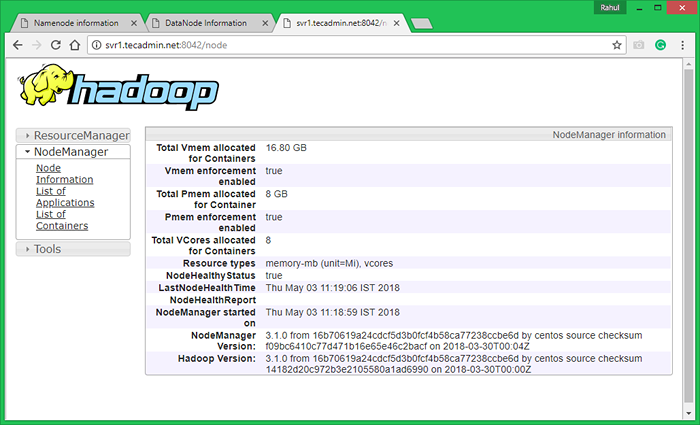

Sekarang akses port 8042 untuk mendapatkan informasi tentang cluster dan semua aplikasi

http: // svr1.tecadmin.net: 8042/

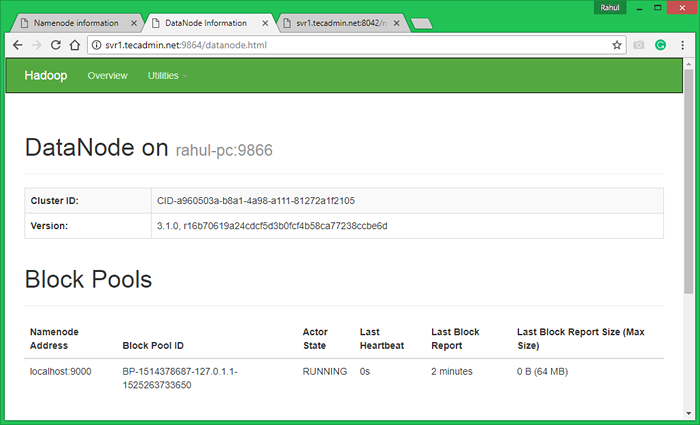

Akses port 9864 untuk mendapatkan detail tentang node hadoop Anda.

http: // svr1.tecadmin.net: 9864/

7. Uji pengaturan simpul tunggal Hadoop

7.1. Buat direktori HDFS diperlukan dengan menggunakan perintah berikut.

bin/hdfs DFS -MKDIR/BIN USER/HDFS DFS -MKDIR/USER/HADOOP

7.2. Salin semua file dari sistem file lokal/var/log/httpd ke sistem file terdistribusi hadoop menggunakan perintah di bawah ini

Bin/HDFS DFS -Put/Var/Log/Apache2 Log

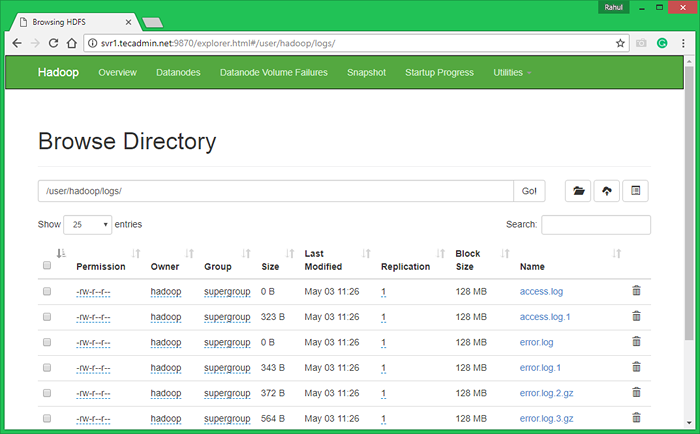

7.3. Jelajahi sistem file terdistribusi Hadoop dengan membuka di bawah URL di browser. Anda akan melihat folder Apache2 dalam daftar. Klik pada nama folder yang akan dibuka dan Anda akan menemukan semua file log di sana.

http: // svr1.tecadmin.net: 9870/explorer.html#/user/hadoop/log/

7.4 - Sekarang Salin Direktori Log untuk Sistem File Terdistribusi Hadoop ke Sistem File Lokal.

BIN/HDFS DFS -GET LOGS/TMP/LOG LS -L/TMP/LOG/

Anda juga dapat memeriksa tutorial ini untuk menjalankan contoh pekerjaan MapReduce WordCount menggunakan baris perintah.

- « 10 hal yang harus dilakukan setelah menginstal ubuntu & linux mint

- Cara menghapus elemen array javascript berdasarkan nilai »